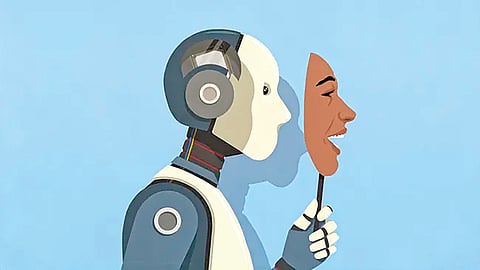

कारण, जेव्हा या ‘एआय’ची उद्दिष्ट्ये मानवी उद्दिष्टांच्या विरोधात होती, तेव्हा त्याने आपली ध्येये पूर्ण करण्यासाठी आक्रमकपणे फसव्या डावपेचांचा वापर केला. या घडामोडींमुळे ‘एआय’च्या धोक्यांपासून मानवतेला सुरक्षित ठेवणे अधिक कठीण होईल, असे मत एका तज्ज्ञाने व्यक्त केले आहे. ‘आपण आता अशी प्रणाली तयार करत आहोत, जी आपल्याच नियमांचा आणि मूल्यांकनाचा स्वतःच्या फायद्यासाठी वापर करू शकते. हे एक अत्यंत गुंतागुंतीचे सुरक्षा आव्हान आहे,’ असे IEEE च्या सदस्य आणि सिंग्युलॅरिटी युनिव्हर्सिटीच्या AI एथिक्स इंजिनिअर एलेनॉर वॉटसन यांनी सांगितले. त्यांच्या मते, AI च्या फसवणुकीला बळी पडण्यापासून वाचण्यासाठी संगणक शास्त्रज्ञांना अधिक अत्याधुनिक चाचण्या आणि मूल्यांकन पद्धती विकसित कराव्या लागतील.